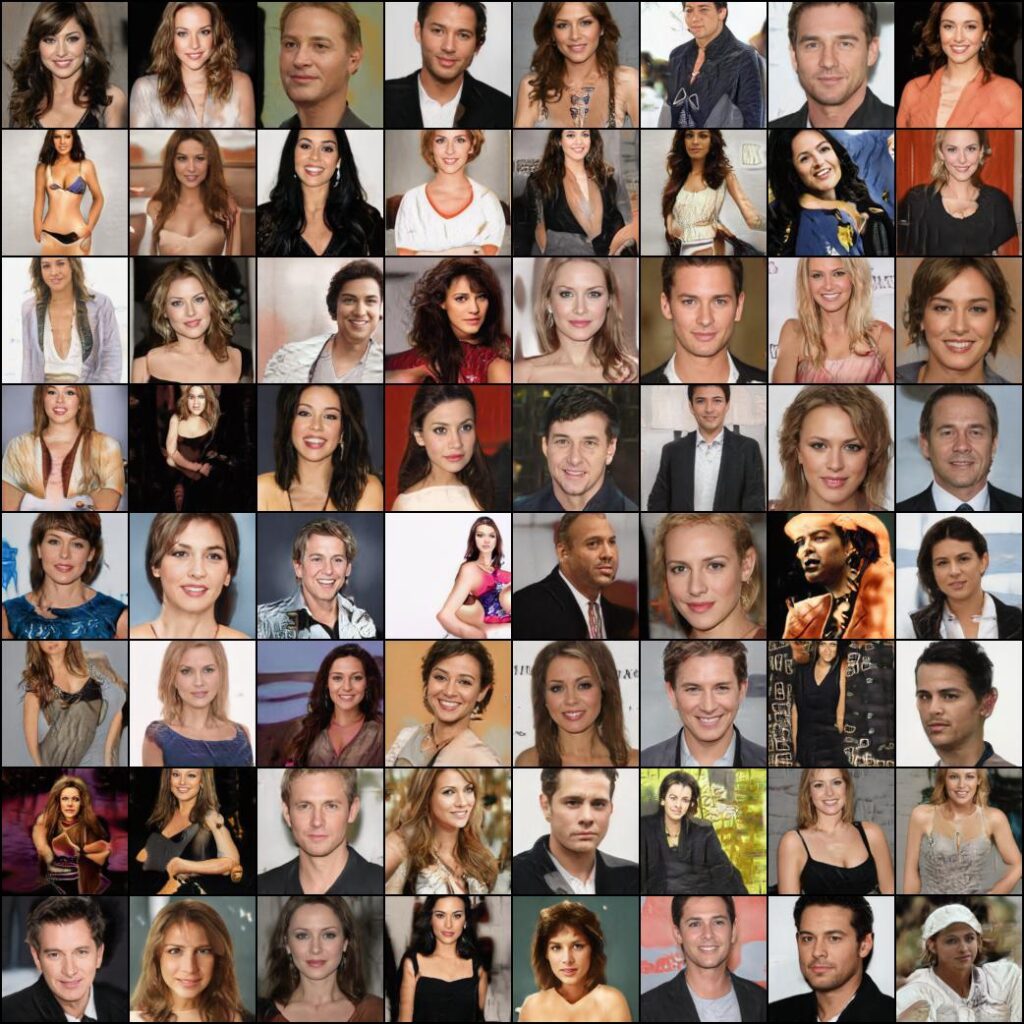

Sito che genera volti di persone che non esistono

Tranquili, sono molto reali (soprattutto i bambini), ma sono persone che non esisto.

Ogni volta che entri nel sito “Thispersondoesnotexist.com” compare un volto umano, che però non corrisponde ad alcuna identità, ma è il frutto di un algoritmo di intelligenza artificiale.

Lo ripeto, le persone non esistono e non sono reali, sono molto fotorealistici ma non corrispondono ad alcuna identità, è un generatore automatico di persone inesistenti e precisamente un algoritmo di intelligenza artificiale dei ricercatori Nvidia (Imagined by a GAN (generative adversarial network) StyleGAN2 – Karras et al. and Nvidia)

Dal loro Server rilasciano un volto ad ogni aggiornamento della pagina, con la possibilità di scaricare il file originale nei formati [original] [simple] [light].

Il sito web è opera di Phillip Wang, un ingegnere di Uber, che in un post su Facebook spiega che si basa sul lavoro di un gruppo di ricercatori della società tecnologica Nvidia pubblicato a dicembre 2018. Questa azienda ha condiviso il suo sistema, proponendo anche modelli per creare gatti , automobili e camere da letto completamente generati dall’intelligenza artificiale.

Altri hanno utilizzato questo metodo per creare personaggi di anime, caratteri e persino graffiti, in quello che potrebbe essere uno strumento utile per designer e illustratori.

La tecnologia utilizzata non è nuova: il sistema utilizza le cosiddette reti neurali, che imitano le connessioni dei neuroni nel cervello e apprendono da un ampio database di esempi.

Le reti neurali sono state utilizzate per generare musica e testi, come nel caso del programma che ha completato la sinfonia incompiuta di Schubert. “Hanno un’ottima capacità di generalizzazione”. Da grandi set di dati possono svolgere con precisione i compiti loro affidati”.

Nel caso di false facce, il compito è stato sviluppato con una rete generativa antagonistica. In questo metodo, una rete neurale genera i volti inventati e un’altra li confronta con quelli originali. Quando questo secondo sistema non è in grado di dire quale delle due immagini è falsa, si presume che nemmeno gli esseri umani saranno in grado di distinguere tale differenza.

Molto molto pericoloso è l’uso dell’intelligence, come iBorderCtrl, che propone di applicare il riconoscimento facciale ai viaggiatori che entrano nell’Unione Europea per rilevare se quest’ultima sta mentendo. Ricordo che i programmi di riconoscimento facciale non solo hanno un alto tasso di errore, ma anche “hanno pregiudizi di genere e di razza. Cioè, hanno più torto con le donne e con le persone che non sono bianche.

Come ha sottolineato uno studio del MIT, la causa è che queste persone sono sottorappresentate nei database utilizzati per addestrare i programmi. Ne abbiamo trovato un esempio nel programma che Amazon ha testato fino al 2017 per selezionare i curriculum dei candidati alle posizioni in azienda: il sistema scartava le donne perché si basava sui profili dei candidati degli anni precedenti, che erano per lo più uomini.

Tutto molto inquietante e posso aggiungere che questo è solo quello che conosciamo pubblicamente.